Paikallinen AI-chat käyttöliittymä (Docker Desktop & Docker Model Runner)

Olen jo aiemmin testannut omalla läppärillä (Apple Macbook Air M1/16GB) paikallisesta ajettavia kielimalleja ja niiden käyttöliittymiä. Tähän asti järjestelmien käyttöönotto ja ylläpito on ollut monimutkaista (Docker + Ollama -yhdistelmä).

Ollamalla mallit saa käyttöön helposti, mutta sen tarjoama chat-käyttöliittymä jättää toivomisen varaa. Kehittyneemmän käyttöliittymän (OpenWebUI) pyörittäminen taas vaatii rinnalle Dockerin. Dockerin & Ollaman yhteiselo ei ole aina täysin mutkatonta, ja molemmat vaativat myös jatkuvaa päivitystä ja ylläpitoa.

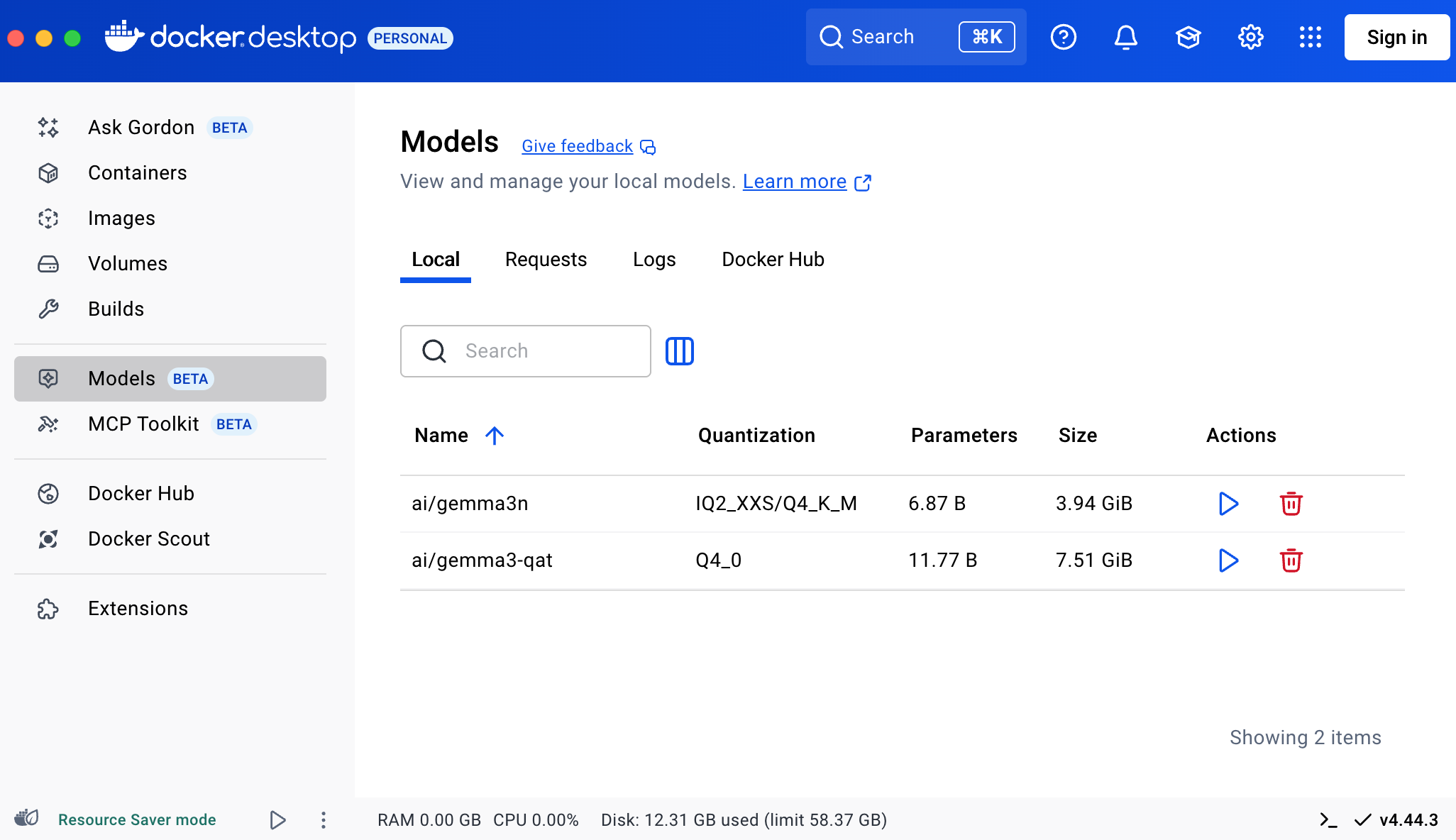

Docker Desktopiin on kesän aikana ilmestynyt Models-valikko, jonka avulla paikallisia malleja voi ladata suoraan Dockerin Hubista. Model Runnerin avulla malleja on mahdollista myös ajaa suoraan Dockerista ilman Ollamaa.

Latasin Docker Hubista Gemma3n-mallin ja loin Docker-kontin tällä docker-compose.yml :llä. (korvaa esimerkin llama-mallia juuri lataamasi mallin tunnisteella)

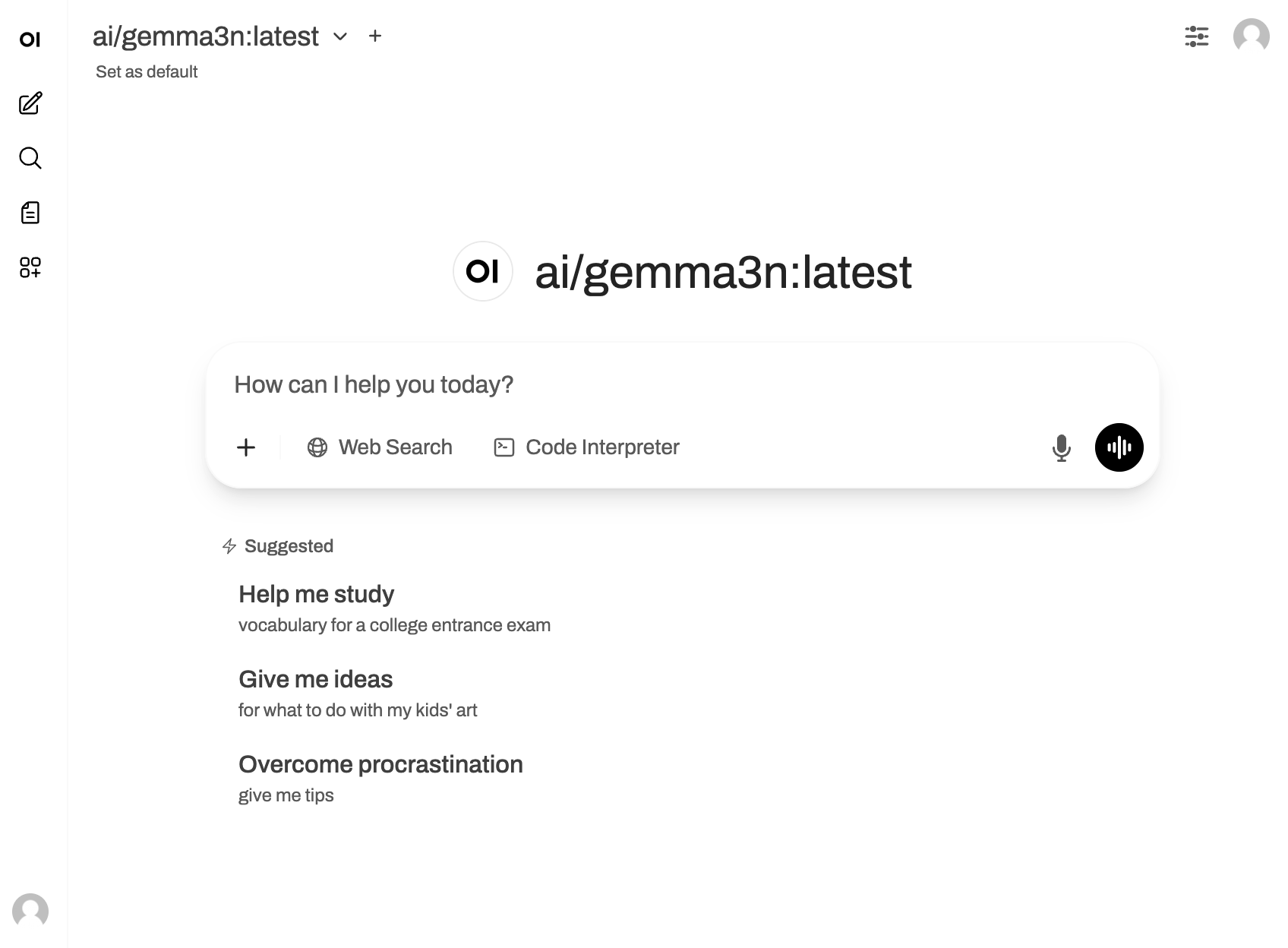

Kun Docker-kontti on asennettu ja käynnissä, verkkoselaimella osoitteesta localhost:3000 löytyy OpenWebUI:n käyttöliittymä, johon luodaan admin-käyttäjä. Tämän jälkeen käyttöliittymä on valmis, ja se käyttää paikallisesti Docker Hubista ladattua Gemma3n-mallia.

OpenWebUI-käyttöliittymään voi liittää API:lla myös muita kielimalleja verkon yli. Niistä lisää myöhemmin.